سئو یکی از مقولههایی است که در آن تفسیر اشتباه دادههای آماری، برداشت اشتباه از مفاهیم SEO و اطلاعرسانی اشتباه به وفور اتفاق میافتد. بخشی از ماجرای اشتباهات مختلف به گوگل و موتورهای جستوجو برمیگردد که اطلاعات دقیق و جزئی در مورد الگوریتمهای رتبهبندی سایتها یا SERP در صفحات نتایج جستوجو منتشر نمیکنند.

گوگل مثل جعبهی سیاهی است که با هوش مصنوعی خاص خود، سایتها را به عنوان نتایج جستجو معرفی میکند و لذا اشتباهات SEO تا حد زیادی ریشه در حفظ اسرار گوگل و ... دارد.

در این مقاله میخواهیم به ۸ اصل اساسی سئو بپردازیم که واقعیت ندارند و یا در گذشته صحیح بودهاند اما در حال حاضر با بهینهسازی الگوریتمها و هوش مصنوعی موتورهای جستوجو، مصداق ندارند و بعضاً غلط هستند و موجب افت بازدید سایت میشوند. با سیارهی آیتی همراه شوید.

گوگل محتوای تکراری را محکوم میکند

منظور از محتوای تکراری یا Duplicate content این است که در صفحاتی از سایت، محتوای تکراری قرار داده شود و شایعاتی در مورد در نظر گرفتن پنالتی برای محتوای تکراری در بسیاری از سایتها مطرح شده است و میشود که حقیقت ندارد!

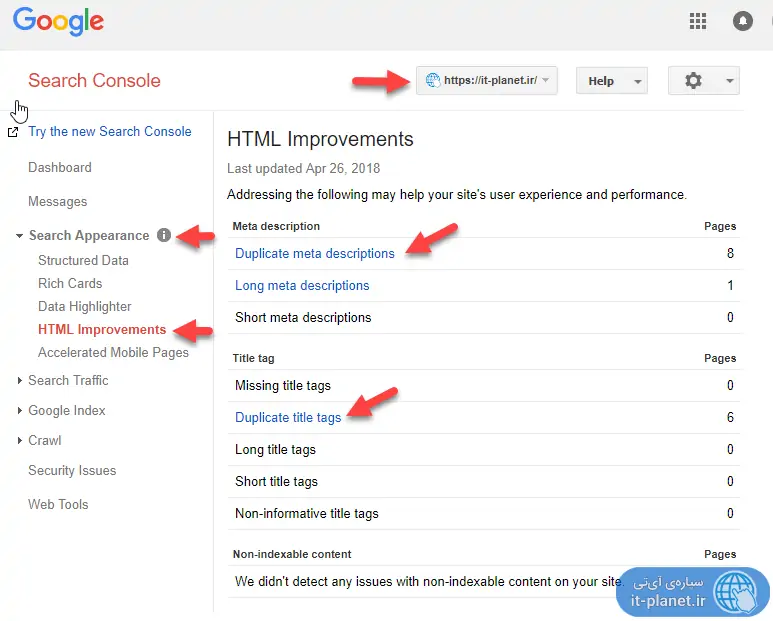

برای چک کردن محتوای تکراری میتوانید از Search Console گوگل استفاده کنید که البته تمام حالتهای محتوای تکراری را معرفی نمیکند اما روش خوب و سریعی است:

حقیقت این است که محتوای تکراری یکی از عنصرهای طبیعی در صفحات سایت است و نمیتوان متن و تصاویر هر صفحه را کاملاً مستقل از دیگر صفحات انتخاب کرد. گوگل تمام صفحات سایتها را بررسی میکند و زمانی که عبارتی جستوجو میشود، تلاش میکند که محتوایی با بیشترین کیفیت و ارتباط معنای عمیقتر را در صدر نتایج نشان دهد. بنابراین صفحاتی از سایتها که به نوعی لیستی از صفحات داخلی را نشان میدهند، علیرغم آنکه دارای محتوای تکراری هستند، مشکلی به وجود نمیآورند.

البته وبسایتی که به صورت کامل از محتوای تکراری تشکیل شده یا به روشهای مختلف سعی در فریب موتورهای جستوجو و بهینه کردن رتبهی خود دارد، طبعاً مشمول جریمههای احتمالی میشود. بدترین حالت این است که صفحاتی از سایت با جمع کردن مطالب صفحات داخلی و به هم پیوستن آن، شبیه یک صفحهی متفاوت جلوه کنند.

خوشبختانه متخصصین سئو با چند راهکار ساده میتوانند صفحاتی که نباید موتور جستوجو ایندکس کند را معرفی کنند و همینطور نسخهی اصلی یک صفحه که چند گونهی مشابه آن در سایت موجود است را به موتور سرچ معرفی کنند. نقشهی سایت یا Sitemap و استفاده از تگ Canonical و همینطور تگهای noindex یا فایل robots.txt از جمله راهکارهای مفید است.

گوگل همواره لینکهای Canonical را در اولویت ایندکس کردن قرار میدهد

اگر یکی از چند نسخهی صفحهای از سایت را با استفاده از تگ canonical به موتور سرچ معرفی کنید، تصور عموم این است که گوگل همان صفحه را به عنوان نسخهی اصلی و غیرکپی در نتایج جستوجو نمایش میدهد. اما اینگونه نیست! وقتی rel را canonical انتخاب میکنید، صرفاً به گوگل کمک کردهاید که صفحهی اصلی را تشخیص دهد حال آنکه ممکن است گوگل در نهایت صفحهی دیگری را به عنوان نسخهی اصلی و غیرتکراری انتخاب کند.

برای مشاهده کردن لیستی از این صفحات خاص، از نسخهی جدید Google Search Console استفاده کنید و در بخش Index Coverage به صفحاتی که با توضیح Submitted URL not selected as canonical مشخص شدهاند، توجه کنید. ممکن است برخی صفحاتی که گوگل به عنوان گونهی اصلی انتخاب کرده، بهتر از انتخاب شما باشد. بنابراین میتوانید تگ canonical را برای این صفحات در نظر بگیرید.

بروزرسانی الگوریتمهای کیفیتی گوگل به معنی جریمه شدن برخی سایتها است

عموم کاربران تصور میکنند که زمانی که یکی از الگوریتمهای کیفی گوگل مثل پاندا یا فنتوم بروزرسانی میشود، برخی سایتها جریمه میشوند و در واقع الگوریتم برای جریمه کردن سایتهایی با محتوای کمکیفیت یا بیکیفیت بروز شده است. اما در حقیقت اینطور نیست.

الگوریتمهایی مثل Panda یا Phantom گوگل، مثل جعبهی سیاهی هستند که ورودیشان تعدادی سایت است و خروجیشان رتبهبندی است. با آپدیت شدن و پیشرفتهتر عمل کردن، رتبهبندی سایتها منطقیتر میشود و طبعاً ممکن است برخی سقوط و برخی صعود کنند اما این به معنی جریمه در نظر گرفتن نیست. صرفاً نمرات و امتیاز سایتها مجدداً محاسبه شده است.

سه فاکتور اصلی رتبهبندی گوگل شامل لینکها، محتوا و RankBrain است

برخی کارشناسان سئو ادعا کرده و میکنند که فاکتورهای اصلی رتبهبندی سایتها در نتایج جستوجو، سه مورد است. لینکها و بکلینکها، محتوا و الگوریتم RankBrain که ترتیب نتایج را تغییر میدهد و حالت بهینه را تخمین میزند، سه فاکتوری است که معمولاً به عنوان سه فاکتور اصلی SEO مطرح میشود.

اما مسؤلین موتور جستوجوی گوگل میگویند نمیتوان سه یا چند فاکتور خاص را به عنوان مهمترین فاکتورها معرفی کرد چرا که بسته به کلمه و عبارت سرچشده، وضعیت متفاوت هست و حتی هر روز با روز بعدی فرق میکند. بنابراین نباید روی برخی فاکتورهای خاص SEO متمرکز شد و عوامل متعدد دیگر را کنار گذاشت. توصیهی متخصصین سئو همواره این است که روی بهینهسازی تجربهی کاربران سایت و بهینه کردن محتوا برای جلب توجه کاربران و در یک کلام کیفیت واقعی سایت وقت صرف کنید و البته آخرین بروزرسانیهای گوگل را نیز دنبال کنید.

الگوریتمهای گوگل سایتهای نو را نادیده میگیرد

یکی از عقایدی که بین وبمسترها مرسوم شده این است که گوگل سایتهایی که نوظهور باشند را مثل سایتهای قدیمیتر در صدر نتایج جستوجو نشان نمیدهد چرا که فیلترهایی برای سایتهای نوپا در نظر گرفته شده است.

در حقیقت ترافیک ارگانیک سایتها در روزها و ماههای ابتدای شروع به کارشان پایین است اما این به علت وجود فیلترهای خاص نیست بلکه الگوریتمهای سنجش کیفیت و بررسی موضوعی سایت، میبایست برای درک محتوای سایت و مقایسه کردن آن با سایتهای مشابهی که تازه شروع به کار کرده، مدتی زمان صرف کنند و طبعاً اگر کیفیت سایتی بالاتر از رقبای نوظهور دیگر باشد، پس از طی کردن فراز و نشیب موقت، در درازمدت SERP بهتری خواهد داشت.

توجه: SERP مخفف رتبه در موتورهای جستوجو است.

بکلینکهای بیکیفیت مضر است

یکی از کارهای اساسی متخصص سئو در گذشته این بوده که مرتباً به بررسی کردن بکلینکها بپردازد و اگر سایتی که محتوای بیکیفیت دارد، لینکی به سایت داده، آن را به عنوان بکلینک بیکیفیت رد کند.

در سالهای اخیر موتورهای سرچ پیشرفت خوبی در شناخت کیفیت بکلینکها پیدا کردهاند و به صورت خودکار بکلینکهای بیکیفیت و مصنوعی را نادیده میگیرند و البته امتیاز منفی نیز برای سایتها در نظر نمیگیرند. بنابراین نیازی به استخدام کردن یک متخصص سئو برای دنبال کردن بکلینکها و حذف کردن بکلینکهای بیمورد و بیکیفیت وجود ندارد.

تنها موردی که توصیه میشود این است که اگر صفحهی از سایت مشمول جریمهی دستی شده، برای حذف کردن بکلینکی که آن را گزارش کرده، اقدام کنید و ابهامات را برطرف نمایید.

گوگل فقط به بکلینکهایی از سایتهایی با Authority بالا بها میدهد

آتوریتی یا میزان اعتبار سایتها بسته به عواملی مثل محتوا، عمر دامین و ... افزایش پیدا میکند. یکی از باورهای غلط این است که در استراتژی بکلینکسازی باید به سایتهایی که آتوریتی بالایی دارند و ارتباط موضوعیشان با موضوع سایت خوب است، استفاده کرد و سایتهایی با آتوریتی پایین، اثر زیادی ندارند.

اما این تفسیر، امروزه کاملاً اشتباه به نظر میرسد که فقط آتوریتی مهم است. گوگل در حال حاضر به ارتباط معنایی بکلینکها توجه ویژهای دارد و آتوریتی در اولویت نیست. به عنوان مثال اگر به دنبال کسب اعتبار از طریق معرفی سایت خود هستید، اگر مقالهای در سایتی که ارتباط موضوعی با سایت شما ندارد منتشر کنید، گوگل کم و بیش آن را نادیده میگیرد، حتی اگر وبسایت موردبحث دارای آتوریتی بسیار بالایی باشد!

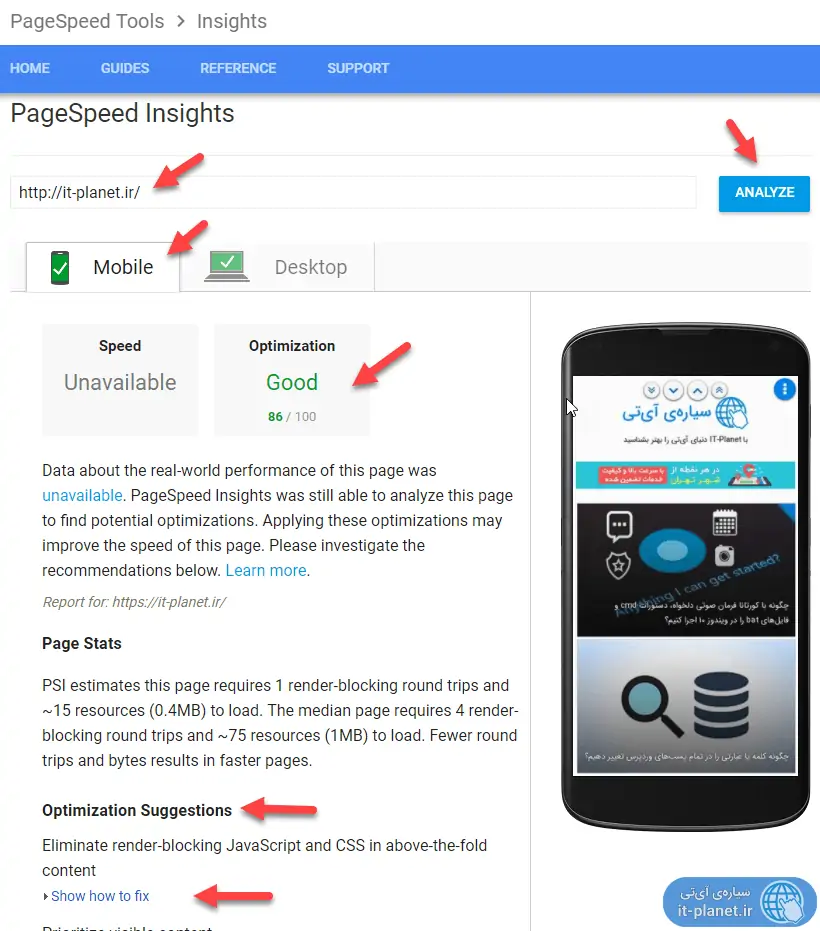

سرعت و امتیاز Page Speed گوگل یک عامل اصلی SEO است

سرویس پیج اسپید گوگل یکی از سرویسهای بررسی سرعت و بهینه بودن طراحی سایت است و امتیاز پیچ اسپید به عنوان یکی از فاکتورهای رتبهبندی سایت در نتایج گوگل از سال ۲۰۱۰ موردتوجه قرار گرفته است. تصور عموم این است که Page Speed گوگل یک فاکتور مهم و اساسی در رتبهبندی سایت اما این برداشت اشتباه است.

گفتنی است که گوگل برنامهای برای بروز کردن سرویس سنجش سرعت سایتها در سال ۲۰۱۸ دارد اما صرفنظر از بروزرسانی موردبحث، امتیاز پیچ اسپید در شناخت صفحات سریع یا کند کاربرد دارد اما رباتهای گوگل در تست و بررسیهای انجام شده، صفحاتی که حتی ۳ دقیقه برای بارگذاری کامل، زمان لازم دارند را هم بررسی میکنند!

اثر سرعت سایت روی تجربهی کاربری کاربران است. بازدیدکننده ممکن است با طولانی شدن بارگذاری صفحهای از سایت، از مطالعه و بررسی آن منصرف شود و این به معنی افزایش نرخ پرش یا Bounce Rate است که غیرمستقیم در SEO اثر میگذارد اما پیچ اسپید یکی از فاکتورهای اصلی و اساسی رتبهبندی سایتها در گوگل محسوب نمیشود.

searchenginejournalسیارهی آیتی